728x90

SMALL

- 이번 긴 설 연휴를 보내며 ADsP 자격증을 준비하기 위해 작성하게 된 글입니다.

- 책이나 기출 변형 문제들을 다뤄보며 작성된 글이기에 미흡한 점이나 오타가 생긴 부분들은 댓글로 지적해주시면 감사하겠습니다. 🙇🏻♂️

- 제가 본 기출에 나왔던 개념이나 언급되었던 표현들은 색을 다르게 하이라이트하였으니 참고 부탁드립니다.

- 그럼 먼저, 1과목인 '데이터 이해' 파트부터 작성해 보겠습니다!

🤔 데이터 이해

✨ 데이터와 정보

- 데이터는 객관적인 사실(Fact)이라는 측면에서 존재적 특성을 가지고, 추론, 예측, 전망, 추정을 위한 근거(Basis)라는 측면에서는 당위적 특성을 가집니다.

- 데이터는 언어나 문자 형태로 이루어져있는 정성적 데이터와 수치, 도형, 기호 등의 형태로 정형화된 정량적 데이터로 나뉩니다.

💡 지식 창조 프로세스

- 일본의 노나카는 지식 창조 메커니즘을 제시해 지식이 축적되는 과정을 설명했습니다. 지식은 총 4개의 과정으로 축적되는데 우선 이 과정에 사용되는 암묵지와 형식지에 대해 정리해보겠습니다.

- 암묵지: 개인의 관심사나 상황 중심적인 지식, 공식화하기 어려운 지식, 다른 사람에게 공유하기 어려운 개인적인 지식을 말합니다. 예를 들어 '김치를 맛있게 담그는 손맛'과 같은 개인적인 것을 뜻합니다.

- 형식지: 체계적인 언어로 전달 가능한 지식, 전달과 공유가 용이한 지식입니다.

- 이 암묵지와 형식지가 지식의 축적 과정에서 어떻게 사용되고 전환되는지 살펴보겠습니다.

- 공동화

- 암묵지를 고차원의 암묵지로 전환하는 과정으로, 조직 내에서 초보적인 경험과 인식을 공유하는 단계입니다.

- 대화를 통해 다음 단계인 표출화 단계로 넘어갑니다.

- 표출화

- 암묵지를 형식지로 전환하는 과정으로, 암묵지가 언어로 표현되어 공식화되는 단계입니다.

- 이 전환된 형식지들을 연결시켜 다음 단계인 연결화 단계로 넘어갑니다.

- 연결화

- 분산된 형식지들을 통합해 새로운 형식지를 창조하는 과정으로, 지식을 체계화해 지식 체계로 만드는 단계입니다.

- 실천을 통한 학습으로 다음 단계인 내면화 단계로 넘어갑니다.

- 내면화

- 형식지를 다시 암묵지로 전환하는 과정으로, 모든 단계를 거쳐 검증받은 모델이나 기술적인 노하우가 개인의 암묵지로 체화되는 단계입니다.

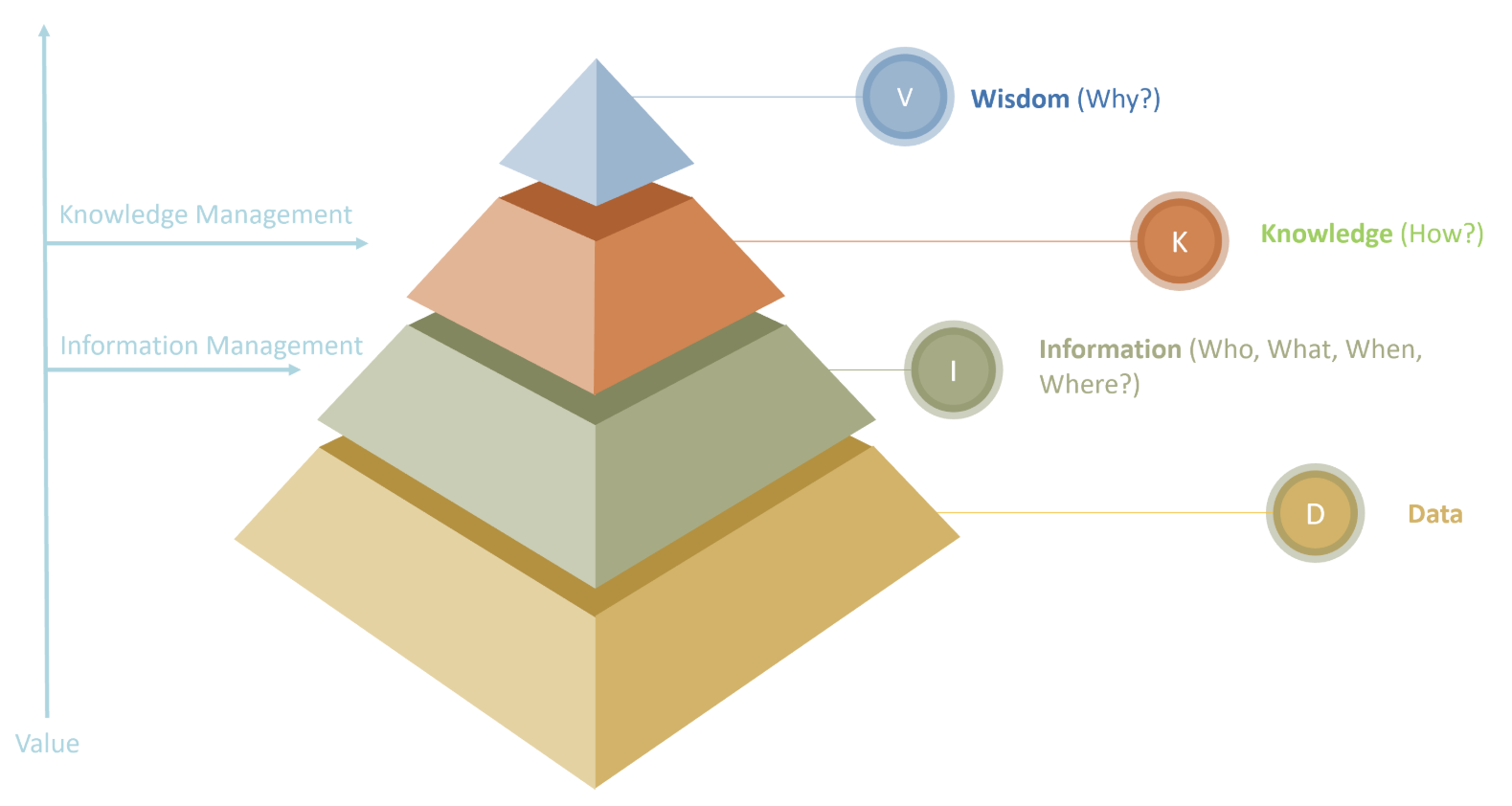

💡 DIKW 피라미드

- 지식 피라미드라고도 불리며, 가장 아래 데이터(Data)로부터 시작해, 가장 위층인 지혜(Wisdom)로 끝나는 피라미드 형태입니다.

- 데이터(Data)

- 존재 형식을 불문하고 타 데이터와는 상관없는 가공 전 순수한 수치나 기호를 의미합니다.

- (A 기업은 해당 책을 10,000원에 판매하고, B 기업은 12,000원에 판매한다.)

- 정보(Information)

- 데이터의 가공 및 상관관계를 이해하여 패턴을 인식하고 의미를 부여한 데이터입니다.

- (A 기업의 책이 더 저렴하다.)

- 지식(Knowledge)

- 정보 패턴을 이해한 뒤, 이를 바탕으로 예측된 결과물입니다.

- (상대적으로 가격이 저렴한 A 회사에서 책을 구매해야겠다.)

- 지혜(Wisdom)

- 근본 원리를 이해 후, 도출되는 창의적인 아이디어입니다.

- (A 기업의 다른 상품들도 B 기업보다 저렴할 것으로 판단했다.)

✨ 데이터베이스의 정의와 특징

- 데이터베이스(DB)는 사용자들이 사용하는 데이터를 저장해 여러 사람들이 같이 공유하며 사용할 수 있는 데이터의 집합체를 의미합니다.

💡 데이터베이스 특징

- 통합된 데이터로, 데이터의 중복 없이 저장해 데이터를 최소화하고, 컴퓨터가 접근 가능한 저장매체에 저장된 데이터입니다.

- 기업의 목적에 맞게 운영할 수 있고, 기업이나 조직이 공동으로 소유하고 활용할 수 있는 데이터입니다.

- 다수의 사용자로부터 데이터 검색/질의에 즉시 응답하고, 지속적인 변환으로 최신 데이터를 유지합니다.

- 여러 사용자가 데이터에 접근하고 공유하며, 데이터의 주소가 아닌 내용에 의해 참조됩니다.

- 요구사항 분석 → 개념 → 논리→ 물리 순으로 설계됩니다.

💡 데이터베이스 장단점

- 장점

- 데이터 중복을 최소화하며, 실시간으로 접근이 가능합니다.

- 데이터 보안을 제공하고, DB의 논리적이고 물리적인 독립성도 제공합니다.

- 데이터 표준이 지켜지며, 데이터 공유, 일관성, 무결성을 제공합니다.

- 단점

- DB 구축에 따른 비용이 발생하고, 백업과 복구가 꽤나 복잡합니다.

✨ 데이터 웨어하우스(DW)

- 기업의 합리적인 의사결정을 위해 기업 내외부 데이터를 통합한 DB의 집합체입니다.

- 기업의 모든 데이터를 하나의 DB에 보관하는 것이 아니라 아래 4가지 특징이 지켜져야 진정한 데이터 웨어하우스입니다!

- 정보를 특정한 주제에 맞게 분류, 가공하여 구조화하는 주제지향적인 특징이 필요합니다.

- 기업 내부의 운영 데이터와 기업 외부에서 수집된 외부 데이터는 통합 후 가공되어야합니다.

- 과거, 현재 데이터를 일정기간 동안 저장해 미래를 예측하고, 시점 별로 분석이 가능하도록 시계열적인 특징이 필요합니다.

- 갱신이 발생하지 않는 조회 전용(Read-Only)의 비소멸성을 지니고 있어야 합니다.

💡 데이터 웨어하우스 구성 요소

- 데이터 모델: 주제지향적으로 설계된 ER 모델로, OLAP으로 다차원 분석을 하기 위한 다차원 모델입니다.

- ETL: 기업 내외부 데이터를 추출(Extract), 정제(Transform) 및 적재(Load)를 수행하는 작업입니다.

- ODS: 다수 OLTP 시스템에서 추출한 데이터를 통합적으로 관리하는 DB입니다.

- OLTP: 거래 단위에 초점을 맞춘 과거 DB 형태로, 호스트 DB에 접근하고, 바로 처리 결과를 되돌려보내는 형태입니다.

- DW Meta Data: 데이터 모델에 대한 정보를 제공하는 운영 Meta Data와 비즈니스 측면에서 정보를 제공하는 활용 Meta Data가 존재합니다.

- OLAP(Online Analytical Processing): 사용자와 대화식으로 다차원 분석을 수행할 수 있는 도구로, 동일 데이터를 여러 차원으로 변경해가면서 분석합니다.

- 데이터마이닝: 데이터로부터 알려지지 않은 사실과 패턴을 분석하는 과정입니다.

- 경영기반 솔루션: 분석을 위한 BSC, RMS, BI, DSS, EIS 등의 경영기반 솔루션입니다.

✨ 데이터베이스 활용

- KMS(Knowledge Management System)

- 조직 내 인력들이 축적한 개별적 지식(암묵지)을 체계화하고 공유하면서 기업의 경쟁력을 향상하려는 기업의 지식 관리 시스템입니다.

- 여기서 KM(지식 경영)은 기업 활동에 필요한 지식을 적시에 획득, 축적, 유통이 가능하도록 고객, 주주, 기업의 가치를 높이려는 활동을 뜻합니다.

- ERP(Enterprise Resource Planning)

- 기업 내 구축되는 DB로 기업 전체의 경영 자원을 효과적으로 이용을 목적으로 경영의 효율화를 위한 정보 시스템입니다.

- 기간 업무 프로세스들을 통합적으로 연계 관리 해주며, 주위에서 발생하는 정보들을 공유하고 실시간 처리를 수행해 빠른 의사결정을 지원하는 전사 자원 관리 패키지입니다.

- SCM(Supply Chain Management)

- 기업이 외부 공급 업체 또는 제휴 업체와 통합된 정보 시스템으로 연계하여, 시간과 비용을 최적화시키는 데이터베이스 시스템입니다.

- 공급자에서 고객까지의 공급사슬 상의 정보, 물자, 현금의 흐름에 대해 총체적 관점에서 프로세스를 통합하고 관리하며 효율성을 극대화하는 전략적 기법입니다.

- 물리적 관계(공급자, 제조자, 고객 등)와 논리적 관계(서비스, 정보, 현금 등)를 통합해 모든 흐름을 거쳐 업체 간 통신 및 의사소통 등을 수행합니다.

- CRM(Customer Relationship Management)

- 기업이 고객과의 관계를 강화하기 위한 전략으로 고객 생애 가치를 극대화하기 위한 경영 전략입니다.

- EAI(Enterprise Application Integration)

- 기업 내부의 연관된 애플리케이션들을 연동해 필요한 정보들을 중앙 집중적으로 통합, 관리할 수 있는 미들웨어 솔루션입니다.

- 클라우드 컴퓨팅(Cloud Computing)

- 인터넷을 사용해 공유 자원을 On-Demand(사용자가 사용한 만큼만 비용을 지불하는) 형태로 이용할 수 있는 서비스입니다.

- 특정 기업만 사용하는 Private Cloud와 누구나 사용 가능한 Public Cloud로 분류됩니다.

- 현재 빅데이터 분석에 있어서 경제성을 제공하는 요소 중에 하나입니다.

- ISP(Information Strategy Planning)

- 조직의 경영 목표 및 비즈니스 전략을 효과적으로 지원하기 위해 정보화 전략을 수립하는 컨설팅입니다.

- BI(Business Intelligence)

- 데이터를 기반으로 기업 활동에 연관된 의사 결정을 돕는 프로세스입니다.

- 가트너에서는 사용자가 필요로 하는 정보를 정확한 시간에 제공할 수 있는 환경으로 정의하고 있습니다.

🤖 데이터의 가치와 미래

✨ 빅데이터의 이해

- 다양하고 방대한 데이터 그 자체를 의미하기도 하지만, 데이터에서 가치를 추출하기 위한 분석 기술을 의미하기도 합니다.

- 데이터는 인터넷, 모바일 등이 등장하게 되면서 Exa Byte에서 Zetta Byte(Tera - Petta - Exa - Zetta!) 정도의 규모를 다루게 되었습니다.

- 그리고 정형 데이터에서 이메일이나 SNS와 같은 비정형 데이터로 유형도 변하고, 구조화된 데이터에서 실시간성을 띠는 데이터로 변화하고 있습니다.

- 과거에는 전수 조사를 수행할 수 있는 기술의 부족으로 표본 조사로 대부분 대체되었지만, 빅데이터와 이를 관리할 수 있는 기술이 뒷받침되게 되면서 전수 조사가 중요시되어가고 있습니다.

💡 빅데이터의 특성

- Volume(규모): 매일 디지털 정보량이 기하급수적으로 폭증하고 있습니다. Tera에서 Petta, Zetta 시대로 진입했습니다.

- Variety(다양성): 시스템 로그, 소셜, 위치 정보 등 데이터의 종류가 다양해졌습니다.

- Velocity(속도): 센서를 이용한 사물 정보 등의 실시간 정보가 증가하면서 데이터의 분석 속도가 중요해졌습니다.

- Veracity(정확성): 질 높은 데이터를 활용해야 분석의 정확도가 높아집니다.

- Value(가치): 데이터는 사용자에게 가치있는 정보를 창출해야 합니다.

💡 3단계 가치 패러다임의 변화

- 디지털화: 아날로그 신호를 0과 1로 표현하는 디지털 시대로 변화하였습니다.

- 연결: 디지털 제품들은 Ad-hoc 방식으로 연결하고 디지털 제품들은 다시 IP 네트워크에 융합되었습니다.

- 에이전시: 그물망으로 연결된 것들을 관리하게 되었습니다.

✨ 빅데이터의 가치와 영향

- 빅데이터 활용을 위한 3대 요소는 자원(빅데이터), 기술(빅데이터 플랫폼), 인력(데이터 사이언티스트)으로 구분됩니다.

- 먼저, 자원인 빅데이터는 가장 중요한 것으로 수집된 데이터는 전처리 과정을 통해 데이터 품질을 확보해야 합니다.

- 빅데이터 플랫폼에서는 분산 파일 시스템을 이용해 데이터를 분산 저장하고, NoSQL, HBase 등을 사용합니다. 이 플랫폼에서 데이터의 다양한 가치가 창출될 수 있습니다.

- 데이터 사이언티스트는 수학, 공학, 경제학 등의 학문을 학습해 실무에서 데이터 분석을 위해 사용합니다.

💡 빅데이터 처리 프로세스

- 관계형 데이터베이스에 저장되어 있는 내부 데이터와 외부 데이터 소스로부터 프로세스가 시작됩니다.

- 외부 데이터들을 수집하기 위해서 컴퓨터 로그 수집, 크롤링, 센싱같은 기술이 동원됩니다.

- 수집된 데이터는 데이터 등급에 따라 분류되고, 유형에 따라서는 정형, 비정형으로 나뉩니다.

- 빅데이터 처리를 위해 하둡 생태계를 이용하여 데이터를 분산 저장합니다.

- 비정형 데이터는 전처리 과정을 걸쳐 데이터를 정형화하고, 여러 기법들로 데이터를 분석합니다.

- 분석된 데이터를 누구에게나 쉽게 전달하기 위해 R이나 BI 툴을 이용해 시각화합니다.

✨ 비즈니스 모델

- 데이터가 가지고 있는 특성이나 관련 분야에 따라 전력, 보건 및 의료, 유통, 관광, 지역 경제 활성화 등에 활용될 수 있습니다.

- 데이터 레이크는 막대한 원시 데이터를 본연의 형식 그대로 저장하는 것을 의미합니다.

- 여러 모델들에 사용되는 데이터 레이크는 데이터를 암호화하거나 ID를 강력하게 관리하고, 접근이나 권한 부여에 적절한 통제가 이뤄져야 안전하게 보호될 수 있습니다.

- 정형 데이터는 RDB(Oracle, MySQL, MS-SQL 등)에 비정형 데이터는 NoSQL(Mongo DB, HBase 등)으로 저장되어야 하고, 여러 서버에 분산하여 저장하는 HDFS(Hadoop Distributed File System)이 활용되는 편입니다.

✨ 위기 요인과 통제 방안

- 대표적인 위기 요인으로는 사생활 침입, 책임 원칙 훼손, 데이터 오용이 있습니다.

- 사생활 침입

- 특정 데이터가 본래 목적 외로 가공되어서 악용될 가능성이 있기 때문에 개인정보를 사용해 분석하는 분석자가 이에 대한 보안을 철저히 해야합니다.

- 예를 들자면, '여행 사실을 SNS에 올린 사람의 집이 범죄의 타겟이 되는 등'의 요인입니다.

- 책임 원칙 훼손

- 분석 대상이 되는 사람들이 예측 알고리즘으로 인해 희생양이 될 가능성이 있기 때문에 기존의 책임 원칙을 강화해야 합니다.

- '범죄 예측 프로그램을 통해 사전 체포'하는 행위가 바로 책임 원칙을 훼손한 예입니다.

- 데이터 오용

- 데이터에 대한 잘못된 인사이트로 인해 비즈니스에 직접적인 손실을 불러올 수도 있기에 데이터 알고리즘에 대한 접근 권한 관리, 객관적인 인증 방안 등이 이루어져야 합니다.

- '테러리스트로 분류된 미 상원의원의 비행기 탑승을 거부하는 행위'를 데이터 오용의 예로 들 수 있습니다.

- 개인 정보를 보호하기 위해 일반적으로 데이터셋에서 개인을 식별할 수 있는 요소들의 전부 혹은 일부를 삭제 / 대체하는 비식별화, 혹은 수집 단계에서부터 근원적으로 개인을 식별할 수 없게 하는 익명 데이터 정보가 사용됩니다.

- 이렇게 빅데이터로 발생 가능한 문제들을 예방하기 위해 알고리즈미스트가 새로운 직업으로 부상하고 있습니다.

💡 비식별화 조치

- 가명 처리

- 개인 정보 중 주요 식별 요소(이름, 주소 등)을 다른 값으로 대체해 개인 식별을 곤란하게 하는 방법입니다.

- 일정한 규칙이 노출되는 방법으로 대체하는 것은 옳지 않습니다.

- 총계 처리 또는 평균값 대체

- 데이터의 총합 값을 보여줌으로써 개별 데이터의 값을 보이지 않도록 하는 방법입니다.

- 단, 특정 속성을 지닌 개인으로 구성된 단체의 속성 정보를 공개하는 것은 그 집단에 속한 개인의 정보를 공개하는 것과 마찬가지이므로 비식별화가 아닙니다.

- 데이터 가치 삭제

- 데이터셋에 구성된 값 중 필요 없는 값 또는 개인 식별에 중요한 값을 삭제하는 방법입니다.

- 범주화

- 데이터의 값을 범주의 값으로 변환해 명확한 값을 감추는 방법입니다.

- 데이터 마스킹

- 말 그대로 개인식별자가 보이지 않도록 처리하여 개인을 식별하지 못하도록 하는 방법입니다.

- 남아있는 정보로 개인을 식별할 수 없어야 하고, 다른 데이터와 결합했을 때에도 유추할 수 없어야 합니다.

✨ 미래의 빅데이터

- 미래의 빅데이터는 지속적으로 구축되는 데이터를 이용해 ML, DL, AI 형태로 발전할 것입니다.

- 빅데이터를 구축하고 분석 및 운영하기 위해서 아래 기본적인 7가지의 테크닉이 필요합니다.

- 연관 분석: 특정 변수들간의 관련성을 분석하는 기술

- 유형 분석: 문서를 분류하거나 조직을 그룹화하는 기술

- 기계 학습: 데이터를 학습해 알려진 특성을 활용하여 예측하는 기술

- 유전(자) 알고리즘: 유전자 데이터 분석으로 특정 알고리즘을 도출하고 활용하는 기술로 선택, 변이, 교차, 대치 등의 연산으로 구성

- 회귀 분석: 독립 변수와 종속 변수 간 어떤 관계가 있는지, 하나의 변수가 다른 변수에 얼마나 영향을 끼치는지 분석하는 기술

- 감성 분석: 특정 주제에 대해 말하거나 글을 쓴 사람의 감정을 분석하는 기술

- 소셜 네트워크 분석: 특정인과 다른 사람의 관계를 파악하고 영향력 있는 사람을 분석하는 기술

💭 가치 창조를 위한 데이터 사이언스와 전략 인사이트

- 데이터 사이언스는 통계학, 수학, 컴퓨터 공학 등의 학문적 지식과 함께 데이터 시각화까지 포함하는 종합적인 학문입니다. 즉, 과거의 통계학과 다르게 총체적인 접근 방법을 사용합니다.

✨ 빅데이터 분석 및 전략 인사이트

- 빅데이터 분석을 위해 데이터 사이언티스트는 수학 및 통계 지식, 정보 기술, 도메인 관련 지식이 모두 갖춰져야 합니다.

- 또한, 빅데이터를 처리하고 분석함에 있어서 필요한 이론적, 기술적 숙련과 관련된 능력인 ML, 통계, 분산 컴퓨팅 등의 하드 스킬도 필요하고, 데이터 가치를 발견하고 기회를 만들 수 있는 스토리텔링, 창의적 사고, 호기심, 커뮤니케이션 능력 등의 소프트 스킬도 필요합니다.

- 가트너는 이 중에서 데이터 관리, 분석적 모델링, 비즈니스 분석, 소프트 스킬을 강조했습니다.

💡 전략적 통찰력과 인문학 열풍

- 외부 환경의 측면에서 단순 세계화인 컨버전스에서 복잡 세계화인 디버전스로의 변화로 인문학의 열풍이 시작되었습니다.

- 또한, 비즈니스의 중심이 제품의 생산에서 서비스로 이동했고, 생산과 관련된 기술의 중심이 아닌 무형 자산인 시장 창조로의 변화도 인문학을 자극시켰습니다.

💡 빅데이터 분석 주제 유형

- 분석 대상(What), 분석 방법(How)에 따라 최적화, 솔루션, 통찰, 발견으로 구분됩니다.

- 최적화: 분석 대상과 분석 방법을 모두 알고 있는 경우에는 문제 해결을 위해 최적화를 진행합니다.

- 솔루션: 분석 대상은 알지만, 분석 방법(솔루션)을 모르는 경우에 솔루션을 찾는 방법으로 분석 과제를 진행합니다.

- 통찰: 분석 방법은 알지만, 분석 대상이 불명확한 경우에는 인사이트를 이끌어내는 방법으로 진행합니다.

- 발견: 분석 대상과 분석 방법 모두 모르는 경우에는 분석 자체를 새롭게 도출해야 합니다.

💡 목표 시점별 분석 기획

- 현재의 과제를 빠르고 단기적으로 해결하기 위해서는 과제 중심의 접근 방법을 사용하고, 장기적으로 분석 과정을 정의하고 지속적인 분석을 하기 위해서는 마스터 플랜 단위로 접근을 합니다.

- 과제 중심의 접근 방법은 문제 해결에 초점을 두고, 마스터 플랜 단위 접근 방법은 분석 과제 정의에 초점을 두게 됩니다.

💡 빅데이터 분석 기획 시 고려 사항

- 가용한 데이터를 확보해야 하고, 이 확보된 데이터의 유형에 따라 실제 분석 방법과 적용 가능한 분석 솔루션을 다르게 해야 합니다.

- 이전 프로젝트에서 사용된 시나리오(Use-case)를 활용하면 최대한 빠르고 정확하게 분석할 수 있습니다.

- 지속적이고 반복적인 분석 활동으로 급변하는 환경에 적응할 수 있도록 해야 합니다. 따라서 일회성 분석 활동이 아닌 지속적 분석 활동을 위해 장애 요소를 제거해야 합니다.

💡 전형적인 의사 결정의 오류

- 로직 오류: 부정확한 가정을 하고, 테스트를 하지 않는 오류로, 작동은 하지만 잘못된 결과를 초래할 수도 있는 오류입니다.

- 프로세스 오류: 분석과 통찰력을 고려하지 않은 오류로, 데이터 수집이나 분석이 너무 늦어져 사용하지 못하게 되는 오류입니다.

✨ 전략 인사이트 도출을 위한 필요 역량

💡 데이터 수집

- 가장 먼저 본인이 수집하는 데이터의 특징을 미리 알고 데이터를 수집하는 것이 중요합니다.

- 앞서 언급했듯, 데이터는 존재적 특징을 가지고 있습니다. 이 특징으로 인해 정성적 데이터와 정량적 데이터로 구분됩니다.

- 또한, 데이터는 목적론적 특징을 지니고 있어, 인식하는 주체에 따라 여러 종류의 데이터로 분류됩니다.

- 주체의 관점에 따라 원본 데이터의 속성 분리, 다른 데이터와의 병합 등이 발생해 새로운 데이터 객체가 생성될 때도 있습니다.

- 수집 활동에 있어서 데이터는 가역 데이터와 불가역 데이터로 구분됩니다.

- 가역 데이터는 생산된 데이터의 원본으로 일정 수준 환원이 가능한 데이터입니다.

- 불가역 데이터는 원본 데이터와 전혀 다른 데이터로, 재생산되었기에 추적이 불가능한 데이터입니다.

💡 데이터 확보 계획 수립

- 먼저 분석 목적에 맞는 데이터를 정의하고, 데이터별로 확보가 가능한지 확인해야 합니다.

- 또한, 기업 내부 데이터에서 확보할 것인지 외부에서 수집할 것인지를 판단해야 합니다.

- 내부에서 확보할 경우에는 필요 데이터에 대한 데이터명, 데이터 설명, 형태, 용량 등 현황 조사를 수행합니다.

- 외부에서 수집해야 할 경우에는 법률상 제약 사항이 없는지 확인하고, 보유 기업과 협의 후 데이터의 공유 가능 여부를 확인해야 합니다.

- 가트너는 단계적으로 Silos, Exchanges, Pools, Commons의 4단계로 데이터를 확보할 것을 발표했습니다.

- Silos: 조직의 독자적인 데이터 생성, 저장 중심의 단계입니다. 외부 데이터는 인터넷을 통해 수집도 가능합니다.

- Exchanges: 기업의 데이터를 외부 기관들과 상호 교환하는 단계입니다.

- Pools: 특정한 활동이나 목적을 위해 모인 연합 등이 상호 협력과 공동의 장을 형성하는 단계입니다.

- Commons: 오픈 방식의 플랫폼을 통해 데이터 공유가 이루어지는 단계입니다.

💡 데이터 분석 방안 설정

- 분석 과제에 대한 추진 가능성을 검토 후에 보유 데이터와 분석 방법론 등을 활용해 해당 이슈를 해결하기 위한 분석 방안을 수립해야 합니다.

- 이슈와 현황을 도출하는 기초 분석 단계를 거쳐 현업 부서, 정보화 팀, 빅데이터 전문가가 함께 어떤 데이터를 활용해 어떤 이슈를 해결할지, 이에 따른 방안도 함께 제시합니다.

- 참고할 만한 국내외 선행 사례들을 고려해 이슈 해결 방안을 모색하고, 최종적으로는 정책 결정자와 최종 사용자 위주의 관점에서 기술되어야 합니다.

728x90

LIST